Des hommes et des robots sociaux : la perception des êtres sociaux chez les agents artificiels

#ZOOM SUR...

Tatjana A. Nazir est directrice de recherche CNRS au sein du laboratoire Sciences Cognitives et Sciences Affectives (SCALab, UMR9193, CNRS / Université de Lille). Ses recherches portent sur le rôle de l'environnement dans le développement des processus cognitifs. Directeur du SCALab, Yann Coello est professeur de psychologie cognitive et de neuropsychologie à l'Université de Lille. Il s'intéresse particulièrement à la façon dont les représentations motrices façonnent la perception des objets et de l'espace ainsi que les connaissances conceptuelles dans des contextes individuels et sociaux, en utilisant des méthodes expérimentales et de neuroimagerie.

La robotique sociale attire de plus en plus l'attention des chercheurs/chercheuses et des concepteurs d'appareils intelligents en raison de son potentiel d'augmentation du bien-être sociétal. Les robots sociaux sont des systèmes d'intelligence artificielle (IA), physiquement incarnés, conçus pour interagir et communiquer avec les humains. Cependant, la façon dont la présence de ces agents artificiels affectera la société est encore mal connue.

De manière générale, les individus sont plutôt sceptiques quant à l'idée de partager la vie quotidienne avec des robots. Bien que certains craignent que les robots prennent notre travail, transforment notre vie sociale ou enregistrent chacun de nos pas, la raison de ce scepticisme peut provenir d'une toute autre source. Notre comportement social a évolué dans un but précis (la survie et la reproduction) et est en partie contraint par des règles/principes. La conception d'agents sociaux artificiels qui ignorent ces règles/principes peut donc engendrer des problèmes. Comme nous le verrons, une source de rejet des robots pourrait être le simple fait que les concepteurs d'appareils intelligents fabriquent des robots à l'image des humains.

Anthropomorphisme et désenchantement

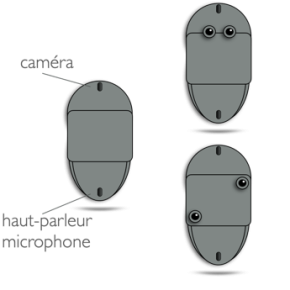

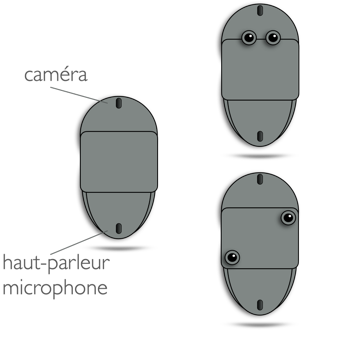

L’humain anthropomorphise. L’anthropomorphisme est l'attribution de caractéristiques humaines à d'autres entités, y compris les animaux, les phénomènes naturels ou les objets inanimés. Dans les interactions humaines, l'anthropomorphisation sert à interpréter les intentions, les pensées et les sentiments des autres (voir à ce sujet la théorie de l'esprit), dans un cadre propre au fonctionnement humain. Alors que les humains peuvent anthropomorphiser de nombreuses choses, y compris leurs voitures et leurs ordinateurs, cette tendance est amplifiée lorsque certains traits/fonctions physiques ou comportementaux sont présents. Ainsi, un ingénieur, testant les compétences linguistiques (une capacité humaine unique) de la dernière IA conversationnelle « LaMDA » de Google, a été amené à croire que l'algorithme était sensible. Un facteur critique qui amplifie notre tendance à anthropomorphiser est la présence de caractéristiques humaines. Équiper un robot de traits qui signalent la présence d’yeux, par exemple, a un effet impressionnant. Les yeux noirs appariés horizontalement suscitent des réponses comportementales spécifiques chez une variété d'espèces animales. La direction du regard permet d’interpréter sur quel élément de l’environnement se porte l’attention des individus que l’on observe. Elle peut signifier l'attention d'un prédateur ou la présence d'un compagnon potentiel. De ce fait, le regard va jouer un rôle déterminant dans l'établissement de hiérarchies de dominance sociale. Chez l'homme, les yeux servent également d'indice pour les états émotionnels. La Figure 1 représente un robot qui se déplace en flottant, qui peut reconnaître votre visage à l’aide d’une caméra et parler grâce à un microphone/haut-parleur. Toutes les fonctionnalités de ce robot sont fournies dans la configuration présentée à gauche de la figure. Sur le robot en haut à droite, deux boutons noirs appariés horizontalement sont ajoutés. Sur le robot en bas à droite, ces mêmes éléments sont disposés différemment. Bien que les deux robots aient exactement les mêmes fonctionnalités, la configuration qui suggère la présence d'yeux (robot en haut) invite davantage à attribuer des caractéristiques humaines (des intentions, des émotions) au robot. À votre avis, lequel de deux est plus obéissant ?1

Des caractéristiques physiques et comportementales particulières suggèrent ainsi la présence de fonctions (humaines) et déclenchent des hypothèses sur l'agent. Par exemple, selon les mouvements effectués par de simples formes géométriques animées, les observateurs peuvent les percevoir comme des personnages dotés d'émotions, d'intentions et d'autres attributs sociaux (Heider & Simmel, 1944)2 . Par ailleurs, l'anthropomorphisation suscite des attentes qui, si elles ne sont pas satisfaites, peuvent créer de la frustration du côté humain. Comme nous l’évoquerons plus tard, ce désenchantement peut être une raison pour laquelle certains d'entre nous sont verbalement grossiers envers des appareils comme l'IA conversationnelle ALEXA.

« Je vois que tu me vois »

Supposons qu'en entrant dans votre bureau/maison, un robot comme présenté dans la Figure 1 se retourne vers vous et dise : « Bonjour [votre prénom], vous avez l'air préoccupé aujourd'hui ». En faisant cela, il signale quelque chose qui est presque banal dans nos interactions quotidiennes avec les agents sociaux, à savoir qu'il vous a « remarqué ». Et de façon générale, les humains semblent adorer être remarqués (« Je vois que tu me vois »). De l'Amérique du Sud à l'Europe en passant par l'Asie, les deux animaux de compagnie préférés des humains sont les chats et les chiens. La raison en est probablement que, contrairement à un poisson dans un bocal, ces animaux signalent qu'ils vous remarquent en réagissent à votre comportement par un contre-comportement qui suit une certaine contingence temporelle. Si vous tendez la main vers votre chien, il peut répondre en mettant sa patte dans votre main (et vous serez enchanté). Un poisson est incapable de suivre votre doigt lorsque vous le faites courir sur la vitre du bocal. Un robot qui se tourne vers vous et s'adresse à vous en utilisant votre nom satisfera cette inclinaison humaine. Notez cependant, que dans les interactions sociales, le timing de ce comportement réciproque est porteur d'informations sociales. Lorsque vous tendez la main pour serrer la main d’un humain, le moment de la réponse de l'autre signale des informations différentes selon que cette réponse arrive retardée ou trop rapide. Au sein de la Fédération Sciences et Cultures du Visuel (SCV, FR2052, CNRS / Centrale Lille / Université de Lille) à Tourcoing, un barman virtuel (Figure 2) est programmé pour réagir à un humain qui avance un verre en direction de l'écran sur lequel il est projeté, en regardant l'humain dans les yeux (signal : je vous ai remarqué) et en prenant une bouteille pour verser une boisson (virtuelle) dans le verre.

En jouant sur les paramètres temporels, il est possible d’introduire un délai entre l'approche du verre et l'action du barman virtuel. Certains participants voient ce retard comme intentionnel (ils anthropomorphisent) et l'interprètent comme un manque de respect de la part du barman virtuel.

Les interactions sociales suivent des règles qui restent souvent inconscientes, mais qui attirent immédiatement notre attention lorsqu'elles sont « mal mises en œuvre ». De tels indices sociaux mal mis en œuvre dans un robot social peuvent déclencher des comportements sociaux de rejet, culturellement déterminés, de la part d'un humain anthropomorphisant.

La dominance sociale et l’abus

En fait, il existe un certain nombre de cas suggérant l’existence de comportements déviants envers les robots. Des robots sociaux travaillant dans l'espace public au Japon, par exemple, sont perturbés par les enfants qui, parfois, les frappent à coups de pied et de poing. HitchBot, un robot auto-stoppeur, a été démembré et détruit de manière irréparable lors d'un voyage à travers les États-Unis. Une expérience plus courante de comportement culturellement déviant envers l'IA est observée lorsqu'il s'agit d'assistants personnels automatisés tels qu'ALEXA ou Assistant Google. Si vous prêtez attention à la façon dont les gens s'adressent à ces appareils, vous constaterez sans doute qu'ils le font souvent d'une manière assez autoritaire, voire grossière, qu’ils n’utilisent pas lorsqu’ils s'adressent à des humains. Amazon et Google se sont sentis obligés d'ajouter une option pour encourager la politesse car certains parents s'inquiétaient des mauvais comportements de leurs enfants et adolescents lorsqu'ils s'adressaient à de tels dispositifs. Qu'en est-il des agents sociaux artificiels qui déclenchent ces comportements culturellement indésirables ?

Certaines personnes diraient que c'est parce que ces appareils sont « tellement stupides », c’est-à-dire qu’ils ne répondent pas aux attentes associées aux agents compétents notamment dans le domaine du langage. D'autres diraient simplement qu'ils le font parce que c'est drôle et parce que les IA et les robots sont des machines qui ne souffrent pas lorsqu'on s’adresse à elles grossièrement. Bien que cette vision soit certainement fondée, cela n'explique pas les comportements dédaigneux, voire violents, que l’on observe parfois chez des personnes cultivées. De plus, nous devons garder à l'esprit que les comportements déviants blessent non seulement la victime, mais aussi les témoins de ces comportements. Une partie de la réponse à cette situation peut résider dans le fait que par leur similitude physique et/ou fonctionnelle avec les humains (qui incite à anthropomorphiser), ces agents sociaux artificiels favorisent l'établissement de hiérarchies sociales et provoquent des comportements qui l’accompagnent (agression et intimidation). Les premiers résultats d'une étude de notre laboratoire faisant varier la ressemblance physique/fonctionnelle des robots avec les humains semblent étayer cette hypothèse. Si un agent social artificiel a des fonctions qui peuvent être simulées avec le corps humain, mais qui semblent moins bien exécutées de celles produites par les humains (par exemple quand, au lieu de marcher, le robot saute pour se déplacer), le rejet du robot est plus susceptible d'être associé à un comportement agressif. En revanche, lorsque les fonctions ne peuvent pas être reproduites avec le corps humain (le robot flotte comme sur la Figure 1), le robot est plus susceptible d'être ignoré que maltraité.

Dès lors, il semblerait que l’objectif visant à concevoir des robots sociaux à l'image des humains est susceptible de rencontrer des obstacles en lien avec la question de l’anthropomorphisme. Par ailleurs, même si l’on envisage pouvoir relever ce défi, un autre problème risque de se poser. En effet, après avoir passé un semestre à enseigner aux étudiants les enjeux des interactions sociales homme-robot, vous risquez d’expérimenter une réaction assez étonnante lorsque vous leur direz : maintenant que vous me connaissez, que penseriez-vous si j'admettais que je suis en fait un robot ? Généralement, on observe une période de silence, voire de stupéfaction, avant que la classe ne s'exprime à nouveau. Ceci indique que, outre l'apparence physique et les fonctions disponibles chez un agent artificiel, il existe une autre caractéristique qui semble avoir de l'importance lors de l'évaluation des robots : leur capacité à générer et contrôler des actions intentionnelles adaptées à leur contexte environnemental et social, autrement dit à montrer des capacités d’agentivité.

- 1En répondant à cette question, vous anthropomorphisez et, par ce biais, vous allez probablement choisir le robot du haut parce que les yeux noirs appariés horizontalement sont des déclencheurs pour anthropomorphiser.

- 2Heider F. and Simmel M. 1944, An experimental study of apparent behavior, The American Journal of Psychology, 57 : 243-259.

Contact