Parole et Langage : 50 ans d'études du son au sens

#VIE DES LABOS

Le Laboratoire Parole et Langage (LPL, UMR7309, CNRS/AMU), situé à Aix-en-Provence, fête cette année ses cinquante ans d’association au CNRS (soixante ans en tant que laboratoire de l’Université) en présence, notamment, d’Antoine Petit, président-directeur général du CNRS, de Marie Gaille, directrice de l’InSHS, et d’Éric Berton, président d’Aix-Marseille Université. L’occasion pour l’unité de faire le point sur son passé, ses avancées, ses questions et ses projets.

Tout nous paraît simple quand nous communiquons par le langage. Mais tout est tellement complexe quand il faut l’expliquer. Tout d’abord, le langage est un système symbolique (fondé sur une convention sociale liant les formes linguistiques à leur sens et à leurs fonctions communicatives) qui possède ses unités (les phonèmes, les morphèmes…) et des possibilités de combinaisons de ces unités (phonologie, syntaxe) ; ces formes et leurs structures prennent sens dans un contexte donné (sémantique et pragmatique).

© Jean-Claude MOSCHETTI/CNRS Photothèque

Parler, c’est aussi mettre notre corps en mouvement : nos poumons, nos cordes vocales, notre langue ainsi que nos mains, nos sourcils, dont l’activité est déterminante pour notre communication. Et puis, nous avons un cerveau pour orchestrer tout cela : non seulement concevoir nos messages, mais aussi programmer nos mouvements, puis traiter le signal acoustique, percevoir et… comprendre. Étudier ce système complexe relève d’approches scientifiques extrêmement variées. Dans notre laboratoire, nous avons la chance d’accueillir des spécialistes de ces questions.

Au départ, il y a cinquante ans, il est principalement question de phonétique au laboratoire. On y étudie les sons du langage, non seulement dans leur fonctionnalité, mais aussi dans leurs aspects physiques, acoustiques et physiologiques. Il s’agit également d’expliquer la « musique » de la parole, terme assez inadéquat pour désigner la prosodie (mélodie, rythme et accentuation), et d’analyser les systèmes de sons dans des langues différentes ou de mieux comprendre à quel point nous sommes flexibles quand nous parlons. Avec la collaboration de cliniciens des centres hospitaliers affiliés au laboratoire, nous étudions aussi la parole et le langage quand ils dysfonctionnent.

De nombreux chercheurs et chercheuses ont rejoint le laboratoire au fil du temps et cela a permis d’interroger nos positionnements et d’aller vers des pistes encore inexplorées. Les questions se sont ainsi multipliées. En quoi nos paroles sont-elles conditionnées par le contexte social, émotionnel, situationnel ? Notre reconnaissance des mots à l’oral est-elle impactée par la lecture ? Comment les créoles se forment-ils ? Comment apprend-on une nouvelle langue ? Peut-on communiquer dans un environnement virtuel ? Comment et pourquoi la maladie de Parkinson affecte-t-elle notre parole ? Quels sont les processus cérébraux en jeu dans la production et dans le traitement de la parole ?

Confronter nos visions, nos questions est au cœur de la démarche interdisciplinaire du laboratoire. « Parler » n'est pas une activité isolée. Le langage, chez l'être humain, est une activité cognitive complexe influencée par de très nombreux facteurs tels que notre mémoire, nos émotions, notre représentation du monde, notre culture, notre milieu social, l'état ou encore les spécificités de notre corps. Le langage est donc une activité composée de toutes ces dimensions. Notre défi ? Essayer de rendre compte de cette activité dynamique composite dans son ensemble plutôt que de superposer des explications parcellaires.

© Jean-Claude MOSCHETTI/CNRS Photothèque

Pour illustrer l’attention que nous portons aux interfaces, nous pouvons évoquer le travail sur la voix chuchotée1 : comment fait-on pour reconnaître des mots dans la parole chuchotée dans laquelle une large partie du signal vocal est absente ? Ce genre de question permet d'interroger des questions fondamentales sur les représentations phonologiques et pratiques, sur les propriétés et le traitement de la voix chuchotée. Sur cette question des représentations, les chercheurs du laboratoire travaillent également sur les influences croisées de modalités (visuelle, motrice vs. auditive) sur nos représentations des mots et suggèrent une influence considérable de la lecture sur nos représentations lexicales dans des tâches n'impliquant pas l'écrit2 .

La prosodie est un point d’intérêt historique dans notre laboratoire. Elle est étudiée pour toutes ses fonctions : de sa capacité à structurer, à segmenter le flux de parole en unités linguistiques ou à discriminer les mots les uns des autres, jusqu'à sa possibilité de porter un sens social (marqueurs prosodiques d'une variété ou d'une identité)3 , de véhiculer des informations conversationnelles (est-ce que je souhaite garder la parole ou au contraire la transmettre ?) et, bien évidemment, une dimension émotionnelle. Elle est étudiée non seulement d’un point de vue phonologique (qui implique des représentations de ces objets), mais également en lien avec les paramètres cognitifs4 , acoustiques et physiologiques de sa production, notamment la respiration.

Ce souci de travailler sur la parole et le langage dans leurs contextes a conduit les membres du laboratoire à mettre la conversation orale et les interactions (que ce soit dans des conversations de la vie de tous les jours ou dans des interactions en classe de langue par exemple) en bonne place dans la liste de leurs objets de recherches. Ainsi, des phénomènes comme la convergence entre locuteurs5 , les réductions phonétiques dans la conversation (de manière similaire à la voix chuchotée, comment fait-on pour comprendre sans difficulté un signal de parole extrêmement partiel et ne correspondant que faiblement à la forme canonique sous-jacente ?) ou des phénomènes linguistiques spécifiques aux conversations comme les signaux d'écoute de l'interlocuteur (souvent des petits mots isolés « mh », « ouais », « d'accord » produits avec des prosodies spécifiques) sont approchés au laboratoire tant par des méthodes expérimentales que par les travaux sur corpus, qualitatifs ou quantitatifs (campagnes d'annotations manuelles, traitement automatique de la langue).

Une force du laboratoire réside dans la diversité de ses membres qui permet par exemple de porter le projet 80PRIME LangDev, qui articule une méthodologie neurolinguistique de pointe fondée sur les mesures électrophysiologiques chez des bébés de 3 à 24 mois avec des analyses quantitatives de l’environnement linguistique et les propres vocalisations des bébés (ce qui requiert d'analyser automatiquement des milliers d'heures de signal). Ce projet devrait permettrait de mieux comprendre comment le développement de l’encodage des sons de parole influence l'émergence de représentations conceptuelles et lexicales chez le bébé.

Enfin, pour terminer ce panorama non exhaustif, il faut souligner le lien puissant qui existe au laboratoire entre les études cliniques (plusieurs membres du laboratoire sont des cliniciens dans les hôpitaux d’Aix-Marseille) et la recherche fondamentale, en particulier dans le domaine des dysarthries — et notamment dans la maladie de Parkinson — qui constitue un modèle pertinent pour comprendre le contrôle moteur de la parole ; inversement, une meilleure compréhension de ces processus permet de mieux accompagner les malades, notamment dans la mise en place de protocoles de rééducation innovants6 .

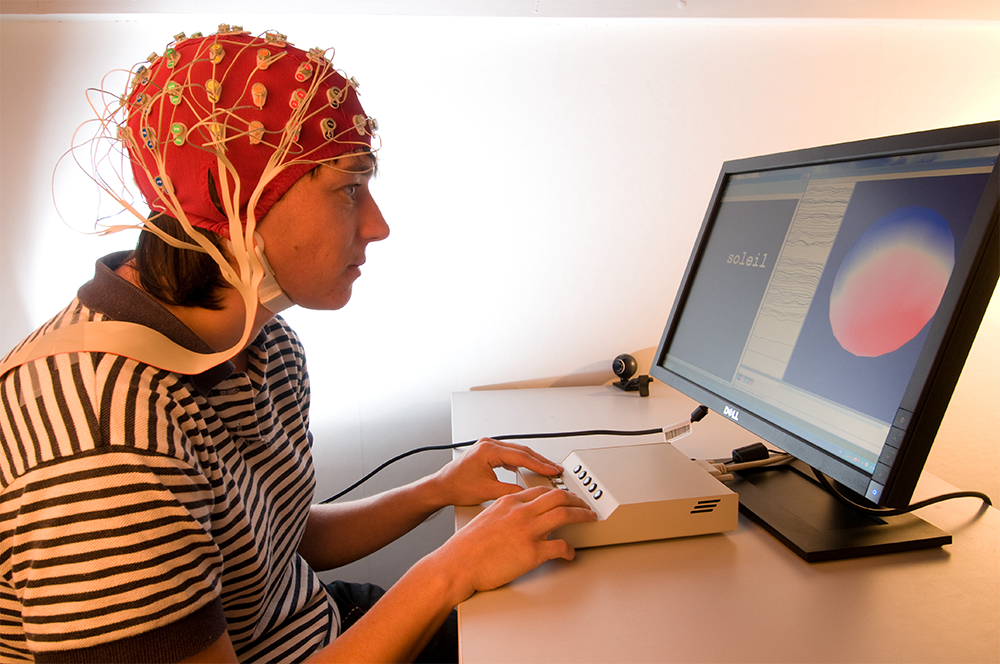

Évidemment, étudier tout cela suppose un large éventail de méthodologies. Notre Centre d’Expérimentation sur la Parole (CEP) nous permet d'entreprendre de nombreux travaux encore inaccessibles il y a quelques décennies : explorer l'activité cérébrale lors du traitement du langage, rendre visible et interprétable l'articulation des sons de la parole, évaluer les déficits liés aux pathologies, traquer le mouvement des yeux lors de la lecture, etc.

Pour cela, les ingénieurs du laboratoire imaginent, conçoivent et construisent des dispositifs expérimentaux sur mesure. Par exemple, la station EVA (Evaluation Vocale Assistée) est un instrument permettant non seulement d’enregistrer la parole, mais aussi de mesurer l’accolement des cordes vocales, le flux d'air buccal et nasal, ainsi que la pression sous-glottique, en particulier pendant que nous parlons. Cet instrument a été utilisé tout particulièrement en phonétique clinique (notamment dans les services hospitaliers ORL et Neurologie comme outil d'aide au diagnostic des pathologies vocales) ; depuis peu, une version mobile est utilisée sur le terrain (en ce moment en Tanzanie) dans le but d'étudier la phonétique articulatoire sur des langues aux propriétés phonétiques particulières et qui n'ont pas encore pu être appréhendées « en laboratoire » à ce jour.

au moyen d'une caméra vidéo © Jean-Claude MOSCHETTI/CNRS Photothèque

Pour aller encore plus près du physiologique, le projet ANIMAGLOTTE consiste à concevoir et développer un « banc larynx » qui permet de reproduire ex vivo la dynamique des plis vocaux observée in vivo. Ce contrôle précis du plan glottique est obtenu grâce au système mécatronique, constitué de sept micro-moteurs qui appliquent des efforts mécaniques conjugués (poussée-traction) pour reproduire l’action des différents muscles intrinsèques du larynx. Le contrôle automatisé du flux d’air (reproduisant l’air expulsé par les poumons) permet l’étude des conditions d’auto-oscillation des plis vocaux pour différentes configurations glottiques reproduites grâce aux sept micro-moteurs.

Enfin, le travail sur les corpus, en particulier les corpus de conversations, est également un point fort de notre laboratoire. Dès les années 2000, des corpus vidéo, associés à une parole enregistrée dans des conditions de laboratoire, ont permis des études des interfaces entre les domaines linguistiques (notamment phonétique, prosodie, syntaxe et interaction). Depuis, de nombreux autres corpus, notamment des corpus multimodaux d'échanges linguistiques virtuels entre étudiants, ont été recueillis, souvent enrichis automatiquement par les méthodes issues du Traitement Automatique des Langues, et analysés, que ce soit par des méthodes qualitatives ou quantitatives.

C‘est cette nature intrinsèquement interdisciplinaire, par la force de ses objets de recherche, qui a conduit notre laboratoire à fonder, en collaboration avec plusieurs autres laboratoires, l’Institut Convergences Langage Communication Cerveau (ILCB) au sein duquel une partie de ces recherches se développent en interaction avec des psycholinguistes, neurolinguistes, informaticiens, mathématiciens, acousticiens… des laboratoires membres de l’ILCB.

Nous avons donc à cœur de sortir des sentiers battus, de confronter nos approches et de tenter de proposer de nouvelles pistes pour mieux comprendre cette activité extraordinairement complexe, mais aussi passionnante qu’est le langage humain. Même si c’est parfois compliqué, nos interactions sont le plus souvent riches, surprenantes, et aboutissent à des projets qui permettent d’aller un peu plus loin dans notre compréhension du langage.

Si tout cela vous intéresse, nous serons heureux de vous accueillir le 15 octobre lors de notre Journée portes ouvertes.

- 1Dufour S., Meynadier Y. 2019, Temporary ambiguity in whispered word recognition: a semantic priming study, Journal of Cognitive Psychology, Taylor & Francis edition, 31 (2) : 157-174.

- 2Pattamadilok C., Sato M. 2022, How are visemes and graphemes integrated with speech sounds during spoken word recognition? ERP evidence for supra-additive responses during audiovisual compared to auditory speech processing, Brain and Language, Elsevier, 225. ⟨10.1016/j.bandl.2021.105058⟩

- 3Portes C., Sneed German J. 2019. Implicit effects of regional cues on the interpretation of intonation by Corsican French listeners, Laboratory Phonology: Journal of the Association for Laboratory Phonology, 10 : 1-26

- 4Petrone C., d'Alessandro D., Falk S. 2021, Individual differences in prosodic imitation, Journal of Phonetics, Elsevier.

- 5Aubanel V., Nguyen N. 2020, Speaking to a common tune: Between-speaker convergence in voice fundamental frequency in a joint speech production task, PLoS ONE, Public Library of Science, 15 (5), pp.e0232209. Priego-Valverde B. 2018, Sharing a laugh at others: Humorous convergence in French conversation, European Journal of Humour Research, International Society for Humor Studies, 6 (3).

- 6Véron-Delor L., Pinto S., Eusebio A., Azulay J-P, Witjas T. et al. 2020, Musical sonification improves motor control in Parkinson's disease: a proof of concept with handwriting, Annals of the New York Academy of Sciences, Wiley, Special Issue: Annals Reports, 1465 (1) : 132-145. Duez D., Ghio A., Viallet F. 2020, Effect of linguistic context on the perception of consonants in Parkinsonian Read French speech, Clinical Linguistics & Phonetics, Taylor & Francis, 35 (10) : 926-944.